[Eine simulationsbasierte OSCE mit Fallpräsentation und Fernbewertung – Entwicklung eines Prototyps]

Lisa Bußenius 1Sigrid Harendza 1

1 Universitätsklinikum Hamburg-Eppendorf, III. Medizinische Klinik, Hamburg, Deutschland

Zusammenfassung

Simulationsbasierte Prüfungsformate verbessern die Möglichkeit, Kompetenzen von Medizinstudierenden während ihrer Performanz bewerten zu können. Zusätzlich ermöglicht die Videoaufzeichnung von Simulationen eine Bewertung ohne Anwesenheit von Prüfenden (Fernbewertung), was Vorteile für Prüfende, Studierende und Prüfungsorganisierende bietet. Wir beschreiben den simulationsbasierten Prototyp einer OSCE inklusive Bewertung der Kompetenzen der Studierenden ohne Anwesenheit von Prüfenden, welcher entwickelt wurde, um eine konventionelle OSCE an der medizinischen Fakultät der Universität Hamburg zu ersetzen. Die Prüfung beinhaltet zwei Phasen: eine Sprechstundenphase mit vier simulierten Patient*innen und eine Fallpräsentationsphase, in der vier Studierende jeweils zwei Fälle vorstellen. Alle Gespräche aus der Sprechstunden- und Fallpräsentationsphase sollen auf Video aufgenommen und von klinischen Prüfenden nach Anschauen der Videos bewertet werden. Fortgeschrittene Medizinstudierende (8. Semester) sollen hinsichtlich ihres klinischen Wissens sowie ihrer Ärzt*innen-Patient*innen-Kommunikation, Clinical-Reasoning-Kompetenz und Patient*innenmanagement-Kompetenz bewertet werden. Wir stellen detaillierte Pläne für die simulationsbasierte OSCE und einen Ablaufplan für die Organisation zur Verfügung. Bei der Pilotierung des Projektes trafen wir auf zwei größere Hindernisse in Bezug auf rechtliche Einschränkungen hinsichtlich der Prüfungsdauer und der Videoaufzeichnung. Dadurch können wir Tipps für die erfolgreiche Implementierung dieses Prüfungsprototyps geben. Wenn erfolgreich umgesetzt, wird eine Abwesenheit der Prüfenden und spätere Bewertung der Videos den Studierenden dabei helfen, sich auf ihr Anamnesegespräch oder die Fallpräsentation zu konzentrieren, die zeitlichen Einschränkungen von Prüfenden reduzieren und außerdem eine randomisierte Bewertung ermöglichen. Etablierte Instrumente für die Kompetenzbewertung statt OSCE-Checklisten zu verwenden ist ein weiteres Merkmal dieses simulationsbasierten OSCE-Prototyps. Rechtliche Fragen können vermieden werden, wenn man den Prototypen als formative Prüfung einsetzt, sollten aber im Vorfeld geklärt werden, wenn die OSCE als summative Prüfung geplant wird.

Schlüsselwörter

Fernbewertung, Kompetenz, OSCE, Prüfung, Simulation

1. Hintergrund

Mit dem Nationalen Kompetenzbasierten Lernzielkatalog für das Medizinstudium [1] werden die medizinischen Curricula in Deutschland zunehmend kompetenzbasiert. Dies erfordert in der Folge die Entwicklung kompetenzbasierter Prüfungsformate. Zurzeit werden objektive strukturierte klinische Prüfungen (OSCEs) – Checklisten-basierte Prüfungen in Anwesenheit von Prüfenden – zur Bewertung der Fähigkeiten von Medizinstudierenden eingesetzt [2]. Um Kompetenzen zu bewerten, können simulationsbasierte Prüfungen mit einem ganzheitlicheren Bewertungsansatz eine größere Aufgabenkomplexität in einem authentischeren Setting erfassen, was den Studierenden ermöglicht, ihre Leistung zu zeigen [3]. Darüber hinaus erlauben Videoaufnahmen von Simulationen eine Fernbewertung, was den Einfluss der Prüfenden auf die Leistungen der Studierenden reduziert [4]. Auch ermöglicht zeitunabhängiges Bewerten eine flexible Arbeitsplanung, was den mit OSCEs verbundenen logistischen Aufwand und die Kosten verringern kann [5]. Um die Kompetenzen fortgeschrittener Medizinstudierender in einer summativen Prüfung bewerten zu können, haben wir einen simulationsbasierten OSCE-Prototyp mit der Option einer Bewertung ohne Anwesenheit von Prüfenden (Fernbewertung) entwickelt.

2. Ziel

Unser Hauptziel war es, eine traditionelle OSCE durch eine simulationsbasierte OSCE zu ersetzen, um eine Bewertung der Kompetenzen der Studierenden zu ermöglichen. Wir nutzen einen evidenzbasierten Ansatz [6], um einen OSCE-Prototyp für diesen Zweck zu entwickeln. Unsere Zielgruppe waren fortgeschrittene Medizinstudierende (4. Studienjahr), welche bereits das nötige Wissen, sowie die Fähigkeiten und Einstellungen erlernt haben, um in einem simulierten Setting handeln zu können.

3. Entwicklung des Prototyps

Für unser Projekt wählten wir eine OSCE am Ende eines Lernmoduls am Ende des 4. Studienjahres im Rahmen des integrierten Modellstudiengangs Medizin Hamburg [7]. Am Ende dieses Moduls müssen die Studierenden in der Lage sein, mit Patient*innen zu kommunizieren und detaillierte Anamnesen zu erheben, Differentialdiagnosen auf der Grundlage von diagnostischen Befunden zu diskutieren und therapeutisches Vorgehen vorzuschlagen. Das vorgesehene Modul umfasst medizinische Themen rund um das Abdomen und Retroperitoneum aus den klinischen Disziplinen Gastroenterologie, Allgemeinchirurgie, Nephrologie und Urologie. Die abschließende OSCE mit rund 200 Studierenden findet an zwei Tagen statt und umfasst sieben fünfminütige Stationen und Checklisten zur Bewertung des klinischen Wissens und der Kommunikationsfähigkeiten.

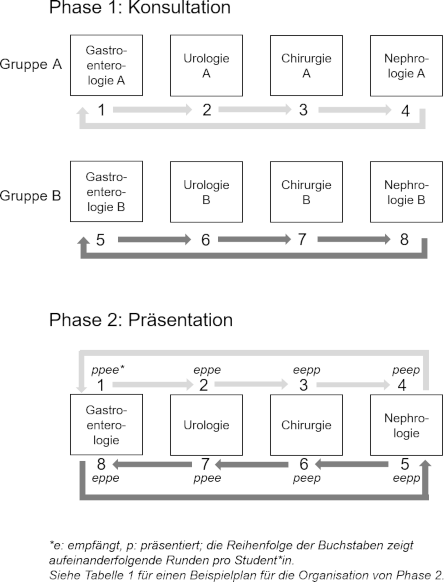

Das Ziel der Neugestaltung der OSCE war es, das klinische Wissen und die kommunikativen Fähigkeiten der Studierenden zu messen, indem ihre Kompetenz in der Ärzt*innen-Patient*innen-Kommunikation, ihre Clinical-Reasoning-Kompetenz und ihre Patient*innenmanagement-Kompetenz bewertet werden, während gleichzeitig die klinischen Inhalte des Moduls abgedeckt werden. Zu diesem Zweck konzipierten wir vier Stationen, die Begegnungen von Ärzt*innen und Patient*innen simulieren (Phase 1: Konsultation), und vier Stationen, die Patient*innenfallpräsentationen in Übergabesituationen simulieren (Phase 2: Präsentation), basierend auf ähnlichen Schritten, die in einer validierten kompetenzbasierten Simulation eines ersten Tages im Krankenhaus [6] verwendet wurden (siehe Abbildung 1 [Abb. 1]). In Phase 1 (Konsultation) rotieren acht Studierende durch vier sechsminütige Stationen in zwei parallelen Parcours, A und B. Die Studierenden, die ihren Startpositionen zufällig zugewiesen werden, treffen auf unterschiedliche Fälle aus jeder der vier klinischen Disziplinen in den beiden Parcours. Zu den Aufgaben der Studierenden an jeder Station gehören die fokussierte Anamneseerhebung bei simulierten Patient*innen und die Besprechung von Testergebnissen, die während des Patient*innengesprächs präsentiert werden. Alle Begegnungen werden auf Video aufgezeichnet, was eine Fernbewertung ermöglicht. Neben der jeweiligen medizinisch-inhaltlichen Korrektheit können auch die Kompetenzen im Bereich Clinical Reasoning und der Ärzt*innen-Patient*innen-Kommunikation mit spezifischen Fragebögen aus der Ferne bewertet werden [8], [9]. In Phase 2 (Präsentation) werden die Gruppen A und B zusammengelegt, sodass sich zwei Studierende in einem Raum zu einer jeweils sechsminütigen Übergabe treffen. Gruppe B rotiert in die entgegengesetzte Richtung von Gruppe A, um eine gleichmäßige Mischung von Studierendenpaaren sicherzustellen. Alle Studierenden präsentieren (p) und empfangen (e) je zwei Patient*innen, so dass in dieser Phase alle vier Disziplinen abgedeckt sind (z. B. in Runde 1 präsentiert (p) Student*in 1 einen gastroenterologischen Fall an Student*in 8, welche*r ihn empfängt (e), während in Runde 2 Student*in 8 einen nephrologischen Fall an Student*in 3 präsentiert (p), welche*r ihn empfängt (e)). Die Aufgabe der Studierenden umfasst die Präsentation und Diskussion jedes Falles, um zu einer Schlussfolgerung bezüglich des Patient*innenmanagements zu gelangen. Analog zu Phase 1 werden in Phase 2 alle Übergaben auf Video aufgezeichnet, was eine Fernbeurteilung ermöglicht. Neben der Bewertung des medizinischen Wissens der Studierenden werden auch die Kommunikationskompetenz [9], [10], das Clinical Reasoning [8] und das Patient*innenmanagement [11] der präsentierenden und empfangenden Studierenden bewertet.

Abbildung 1: Rotationspläne für Phase 1 und 2 der simulationsbasierten OSCE

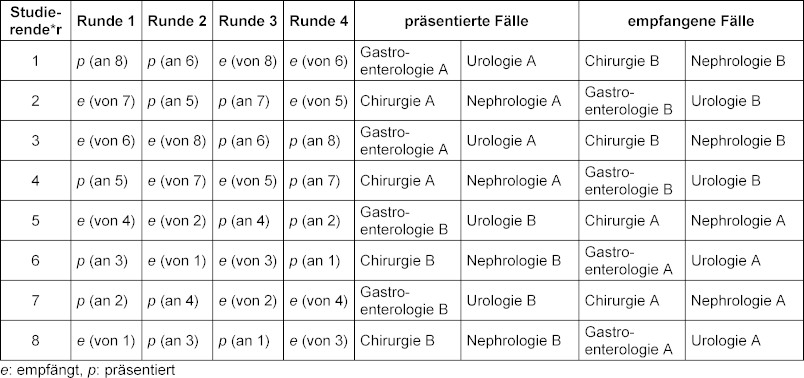

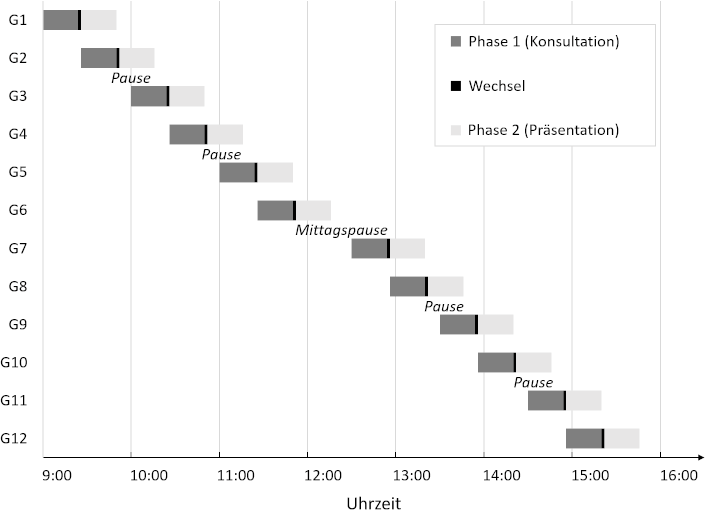

Mit einer Minute für den Wechsel zwischen den Ärzt*innen-Patient*innen-Begegnungen und zwischen jeder Übergabe sowie zwei Minuten für den Wechsel von Phase 1 (Konsultation) zu Phase 2 (Präsentation) dauert die simulationsbasierte OSCE 56 Minuten. Bei überlappenden Phasen (d. h., wenn Gruppe 1 in die Präsentationsphase startet, kann eine neue Gruppe mit der Konsultationsphase beginnen) können 100 Studierende an einem Tag während der normalen Arbeitszeit mit angemessenen Pausen für die simulierten Patient*innen geprüft werden (siehe Abbildung 2 [Abb. 2]). Mit Fernbewertung müssen keine klinischen Fachprüfer*innen währenddessen anwesend sein und können die Bewertung durchführen, wenn sie keine klinischen Verpflichtungen haben. Alle Studierenden erhalten acht verschiedene Bewertungen, vier aus Phase 1 und vier aus Phase 2, d. h. zwei aus jeder Disziplin (siehe Tabelle 1 [Tab. 1]).

Tabelle 1: Beispielplan für die Organisation von Phase 2 (Präsentation)

Abbildung 2: Ablaufplan für einen Prüfungstag der simulationsbasierten OSCE

4. Fallstricke und Tipps für die Implementierung

Wir haben die simulationsbasierte OSCE als summatives Assessment im Juli 2019 mit 186 Studierenden pilotiert [12]. Aufgrund der zeitlichen Beschränkungen in der Prüfungsordnung unserer medizinischen Fakultät hatten wir jedoch nur 42 Minuten Zeit, um sieben Fächer in unsere Bewertung einzubeziehen. Daher konnten wir unser geplantes Design mit den zwei Phasen, das 56 Minuten benötigt hätte, nicht umsetzen. Tipp 1: Wenn Sie diesen Prototyp mit einer Konsultations- und einer Präsentationsphase mit Wechselzeiten einsetzen möchten, finden Sie heraus, ob es in der Prüfungsordnung Ihrer medizinischen Fakultät Beschränkungen für die Prüfungszeit gibt. In unserem Fall mussten wir uns an das traditionelle OSCE-Format halten und die Präsentationsphase streichen.

Außerdem durften wir die Gespräche, die die Studierenden mit den simulierten Patient*innen führten, aus rechtlichen Gründen an unserer medizinischen Fakultät nicht filmen. Daher konnte die Fernbewertung, ein Hauptmerkmal der Bewertung in unserem Prototyp, nicht stattfinden. Tipp 2: Wenn Sie die Fernbewertung einsetzen möchten, klären Sie mit Ihrer Rechtsabteilung, ob es möglich ist, Videos von Studierenden für die Fernbewertung aufzunehmen. Tonbandaufnahmen könnten eine Alternative sein, wenn diese erlaubt sind.

Immerhin konnten wir den Kerngedanken unseres Projekts beibehalten, indem wir Elemente einer Simulation in das traditionelle OSCE-Format einführten. Die Studierenden betraten die Untersuchungsräume, ohne zu wissen, welche medizinischen Inhalte der vier klinischen Disziplinen sie bei bestimmten simulierten Patient*innen erwarten würden, was gute Fähigkeiten bei der Anamneseerhebung erfordert. Tipp 3: Passen Sie die Patient*innenfälle an reale Fälle an und entwickeln Sie sie gemeinsam mit erfahrenen Kliniker*innen, um die inhaltliche Validität zu erhöhen [13].

Anstelle von Videobewertungen mussten unsere Prüfer*innen für ihre Bewertungen im Raum anwesend sein, griffen aber nicht in die Studierenden-Patient*innen-Kommunikation ein. Außerdem konnten die Prüfer*innen aufgrund der Prüfungsordnung der Medizinischen Fakultät Hamburg, die eine bestimmte Punktzahl pro OSCE-Station vorschreibt, die von uns für die Konsultationsphase geplanten Bewertungsinstrumente für die Clinical-Reasoning-Kompetenz [8] und Patient*innen-Kommunikationskompetenz [9] nicht einsetzen. Statt nur medizinische Inhalte zu bewerten, konnten wir zumindest Aspekte von Clinical Reasoning und Kommunikation zusätzlich zu den medizinischen Inhalten in unsere üblichen OSCE-Checklisten integrieren. Als zusätzliches Lehrforschungsprojekt durften Bewerter*innen mit psychosozialem Hintergrund mit in die Prüfungsräume, um die Kommunikationskompetenz der Studierenden mit der Global Rating Scale [9] zu beurteilen. Tipp 4: Bevor Sie die vorgeschlagenen Instrumente zur Kommunikationskompetenz, zum Clinical Reasoning und zum Patient*innenmanagement einsetzen, überprüfen Sie, ob diese in Ihrer Prüfungsordnung für die summative Bewertung zulässig sind.

Aufgrund der prüfungsrechtlichen Bestimmungen an der Medizinischen Fakultät Hamburg konnten wir die simulationsbasierte OSCE mit kompetenzbasierter Fernbewertung nicht als Ersatz für unsere übliche summative OSCE durchführen. Teile der Simulation, d. h. Konsultationen und Fallpräsentationen mit Fernbewertung des Clinical Reasonings, der Kommunikationskompetenz und des Patient*innenmanagements, wurden jedoch bereits an anderer Stelle erfolgreich durchgeführt [8], [9], [10], [11]. Der vorgeschlagene Prototyp funktioniert sogar als telemedizinisches Format, das wir in einem erweiterten Format als formatives Assessment inklusive Feedback implementiert haben [13]. Die zeitunabhängige Fernbeurteilung lässt sich gut mit den Dienstplänen der Prüfer*innen vereinbaren. Zu den weiteren Vorteilen der Fernbewertung gehört, dass die Videos in einer randomisierten Reihenfolge bewertet werden können, um Verzerrungen durch Reihenfolgeeffekte zu vermeiden [14], und dass die Prüfer*innen nach eigenem Ermessen Pausen einlegen können, um mögliche „Prüfenden-Ermüdung“ zu verringern [15]. Darüber hinaus hilft die Verblindung der Studierenden bezüglich des Inhalts der Stationen, sie auf reale Konsultationen vorzubereiten, bei denen die Ursache für das Problem eines Patienten bzw. einer Patientin unbekannt ist. Außerdem erfordert die Fernbewertung weniger Personal vor Ort, während die Prüfung stattfindet. Wenn die Einführung dieses OSCE-Formats in Erwägung gezogen wird, empfiehlt es sich, die zu erwartenden Hindernisse, wie z. B. die begrenzte Prüfungszeit oder mögliche rechtliche Probleme mit dem Filmen oder der Datenspeicherung, im Vorfeld der Planung zu klären.

Förderung

Diese Arbeit entstand im Studierendenauswahl-Verbund (stav), welcher vom Bundesministerium für Bildung und Forschung im Zeitraum von Juli 2018 bis Dezember 2021 gefördert wurde (Förderkennzeichen 01GK1801A). Der Förderer spielte keine Rolle im Studiendesign und bei der Erhebung, Analyse und Interpretation der Daten oder dem Verfassen des Manuskripts.

Ethik

Die Unbedenklichkeit der Studie sowie die Übereinstimmung mit der Erklärung von Helsinki wurde von der Ethik-Kommission der Ärztekammer Hamburg bestätigt (Referenz-Nummer: WF-047/16). Die Anonymität der Teilnehmenden wurde garantiert.

Danksagung

Wir danken allen teilnehmenden Medizinstudierenden, Schauspielern und Schauspielerinnen, Prüfern und Prüferinnen sowie dem Dekanat der Medizinischen Fakultät Hamburg für ihre Unterstützung bei der Pilotierung dieses Prüfungsformats.

Interessenkonflikt

Die Autorinnen erklären, dass sie keinen Interessenkonflikt im Zusammenhang mit diesem Artikel haben.

Literatur

[1] Fischer MR, Bauer D, Mohn K, NKLM-Projektgruppe. Finally finished! National competence based catalogues of learning objectives for undergraduate medical education (NKLM) and dental education (NKLZ) ready for trial. GMS J Med Educ. 2015;32(3):Doc35. DOI: 10.3205/zma000977[2] Newble D. Techniques for measuring clinical competence: objective structured clinical examinations. Med Educ. 2004;38(2):199-203. DOI: 10.1111/j.1365-2923.2004.01755.x

[3] Rotthoff T, Kadmon M, Harendza S. It does not have to be either or! Assessing competence in medicine should be a continuum between an analytic and a holistic approach. Adv Health Sci Educ Theory Pract. 2021;26(5):1659-1673. DOI: 10.1007/s10459-021-10043-0

[4] Yeates P, Cope N, Hawarden A, Bradshaw H, McCray G, Homer M. Developing a video-based method to compare and adjust examiner effects in fully nested OSCEs. Med Educ. 2019;53(3):250-263. DOI: 10.1111/medu.13783

[5] Vivekananda-Schmidt P, Lewis M, Coady D, Morley C, Kay L, Walker D, Hassell AB. Exploring the use of videotaped objective structured clinical examination in the assessment of joint examination skills of medical students. Arthritis Rheum. 2007;57(5):869-876. DOI: 10.1002/art.22763

[6] Prediger S, Schick K, Fincke F, Fürstenberg S, Oubaid V, Kadmon M, Berberat PO, Harendza S. Validation of a competence-based assessment of medical students' performance in the physician's role. BMC Med Educ. 2020;20:6. DOI: 10.1186/s12909-019-1919-x

[7] Rheingans A, Soulos A, Mohr S, Meyer J, Guse AH. The Hamburg integrated medical degree program iMED. GMS J Med Educ. 2019;36(5):Doc52. DOI: 10.3205/zma001260

[8] Fürstenberg S, Helm T, Prediger S, Kadmon M, Berberat PO, Harendza S. Assessing clinical reasoning in undergraduate medical students during history taking with an empirically derived scale for clinical reasoning indicators. BMC Med Educ. 2020;20:368. DOI: 10.1186/s12909-020-02260-9

[9] Bußenius L, Kadmon M, Berberat PO, Harendza S. Evaluating the Global Rating scale's psychometric properties to assess communication skills of undergraduate medical students in video-recorded simulated patient encounters. Patient Educ Couns. 2022;105(3):750-755. DOI: 10.1016/j.pec.2021.06.001

[10] Gärtner J, Bußenius L, Schick K, Prediger S, Kadmon M, Berberat PO, Harendza S. Validation of the ComCare index for rater-based assessment of medical communication and interpersonal skills. Patient Educ Couns. 2022;105(4):1004-1008. DOI: 10.1016/j.pec.2021.07.051

[11] Brätz J, Bußenius L, Brätz I, Grahn H, Prediger S, Harendza S. Assessment of final-year medical students’ entrustable professional activities after education on an interprofessional training ward: A case-control study. Perspect Med Educ. 2022;11:266-272. DOI: 10.1007/s40037-022-00720-0

[12] Bußenius L, Harendza S. Are different medical school admission tests associated with the outcomes of a simulation-based OSCE? BMC Med Educ. 2021;21:263. DOI: 10.1186/s12909-021-02703-x

[13] Harendza S, Gärtner J, Zelesniack E, Prediger S. Evaluation of a telemedicine-based training for final-year medical students including simulated patient consultations, documentation, and case presentation. GMS J Med Educ. 2020;37(7):Doc94. DOI: 10.3205/zma001387

[14] Burt J, Abel G, Elmore N, Campbell J, Roland M, Benson J, Silverman J. Assessing communication quality of consultations in primary care: initial reliability of the Global Consultation Rating Scale, based on the Calgary-Cambridge Guide to the Medical Interview. BMJ Open. 2014;4:e004339. DOI: 10.1136/bmjopen-2013-004339

[15] McLaughlin K, Ainslie M, Coderre S, Wright B, Violato C. The effect of differential rater function over time (DRIFT) on objective structured clinical examination ratings. Med Educ. 2009;43(10):989-992. DOI: 10.1111/j.1365-2923.2009.03438.x